AI Act Fase 1: stappenplan voor onacceptabele risico's

Samenvatting: De AI Act, of AI-verordening, is een Europese wet die veilige en ethische AI-toepassingen stimuleert en regels stelt voor AI-systemen. Sinds 1 augustus 2024 is deze wet van kracht, met een gefaseerde invoering vanwege de complexiteit. Fase 1 moet vóór 1 februari 2025 voltooid zijn. In deze blog lees je hoe je aan de eisen voor deze eerste fase kunt voldoen.

Wat houdt Fase 1 van de AI Act in?

Het invoeren van de AI Act kan niet van de ene op de andere dag; de risicogebaseerde aanpak vereist zorgvuldige planning en naleving. De Europese Commissie heeft een tijdlijn opgesteld met deadlines. Organisaties moeten vóór 1 februari 2025 aan de voorwaarden van de eerste fase voldoen.

Om te voldoen aan de eerste fase geldt: de AI-systemen met een onacceptabel risico zijn verboden. Daarnaast moeten medewerkers binnen de organisatie beschikken over voldoende vaardigheden, kennis en competenties voor het gebruik van AI. 'AI-geletterdheid' noemen we dat.

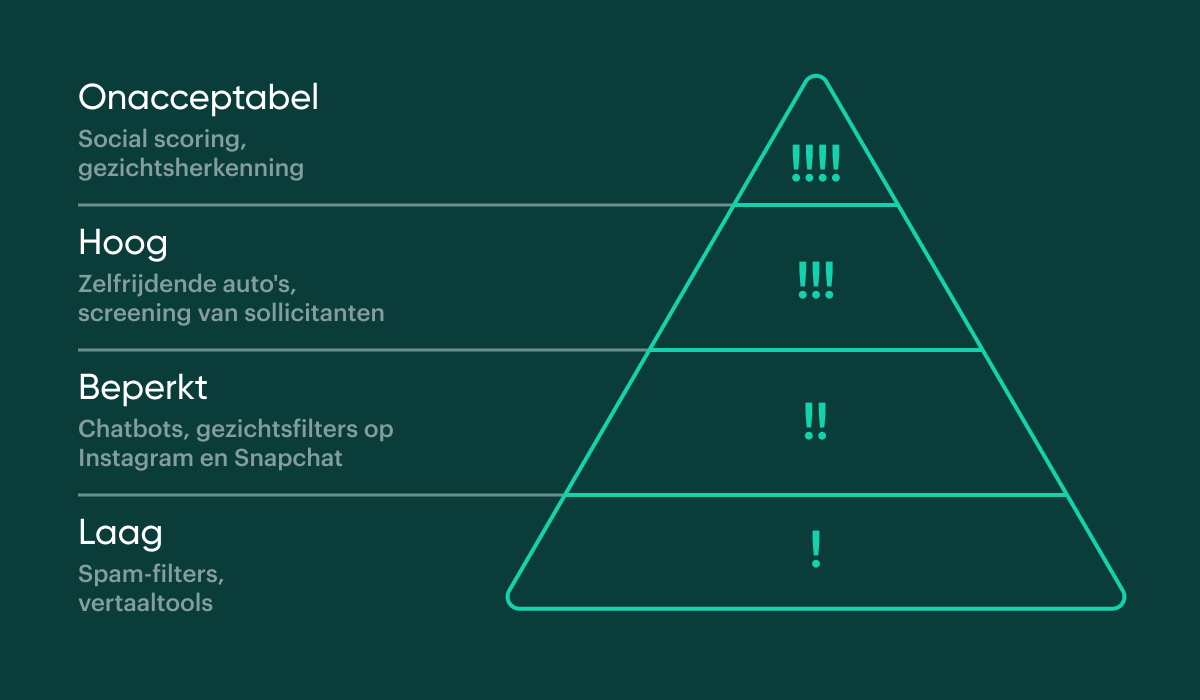

In de eerste blog uit deze serie, 'De invloed van AI op de overheid', vertelden we over de risicogebaseerde aanpak. Zie de afbeelding hieronder met de risicocategorieën volgens de AI Act:

Verderop in deze blog geven we in een stappenplan tips om medewerkers AI-geletterd te maken. Eerst werpen we een blik op de AI-toepassingen met een onacceptabel risico die per 1 februari 2025 verboden zijn.

Onacceptabele risico's binnen AI

De AI Act beschouwt de onderstaande AI-systemen als 'onacceptabel', omdat ze mogelijk een bedreiging vormen voor burgers:

Subliminale manipulatie

AI-systemen die mensen beïnvloeden op een manier waardoor ze hun gedrag of keuzes veranderen zonder dat ze zich hiervan bewust zijn, worden gezien als vormen van subliminale manipulatie. Dit type manipulatie kan leiden tot schade of misbruik van kwetsbare mensen.

Vooral op social media speelt dit risico een rol. In 2016 gebruikte Cambridge Analytica gegevens van 50 miljoen Facebookprofielen om kiezers in de VS persoonlijk te beïnvloeden. Met technieken zoals microtargeting werden gebruikers gericht benaderd op basis van hun angsten en verlangens, wat hielp om de campagne van Donald Trump te ondersteunen. Ook de inzet van nepaccounts op Facebook en Instagram versterkte dit effect.

Exploiteren van kwetsbare groepen

AI-systemen kunnen mensen in een kwetsbare positie manipuleren, benadelen of oneerlijk belasten. Groepen zoals mensen met een migratieachtergrond, ouderen of mensen met een beperking lopen hierdoor meer risico op strafmaatregelen, hogere kosten of inbreuk op hun privacy.

Het toeslagenschandaal laat goed zien hoe het mis kan gaan. Tussen 2013 en 2019 gebruikte de Belastingdienst algoritmes om fraude op te sporen bij kinderopvangtoeslag. Mensen met een laag inkomen of een migratieachtergrond werden daarbij onterecht als fraudeurs bestempeld. Dit leidde tot grote financiële en emotionele schade voor duizenden gezinnen.

Social scoring

Bij 'social scoring' wordt een sociale kredietscore meegegeven op basis van gedrag, sociale status of persoonlijke kenmerken. Wanneer overheden gebruik maken van dit soort AI-systemen, kunnen burgers beoordeeld en bestraft of beloond worden op basis van hun gedrag. Dit kan leiden tot discriminatie en ongelijkheid.

In China wordt social scoring toegepast. Chinezen krijgen plus- en minpunten toegewezen voor hun kredietachtergrond, het nakomen van contracten, maar ook voor hun gedrag en hun vriendschappen. Bij een te lage score word je bijvoorbeeld geweigerd in de trein of het vliegtuig.

Real-time biometrische identificatie in openbare ruimtes

Handhavingsdiensten, zoals politie en douane, mogen in openbare ruimtes geen real-time biometrische identificatie (RBI) gebruiken, zoals gezichtsherkenning. Dit soort AI-systemen monitoren continu wie zich in een bepaalde ruimte bevindt, wat een ernstige inbreuk op de privacy vormt. Er zijn wel uitzonderingen mogelijk, zoals bij ernstige criminaliteit of terroristische dreigingen, maar deze moeten strikt gereguleerd en gecontroleerd worden.

Op sommige luchthavens wordt gebruik gemaakt van het Self Service Passport Control-systeem (SSPC), een gezichtsherkenningstechnologie om passagiers te identificeren en te controleren. Dit versnelt het incheck- en beveiligingsproces. Op Schiphol wordt dit al een aantal jaar toegepast.

Misbruik van emotieherkenning en gedragscategorisatie

AI-systemen die emoties of bepaalde gedragingen van individuen herkennen en daar conclusies aan verbinden, kunnen leiden tot discriminatie of misbruik.

Het gebruik van emotieherkenning om sollicitanten te beoordelen kan leiden tot oneerlijke keuzes. Deze technologie kijkt naar iemands gedrag en emoties op dat moment, maar dit zegt niets over wie die persoon echt is.

Hoe voldoe je aan Fase 1 van de AI Act?

Je hebt nog tot 1 februari 2025 de tijd om aan de eisen van fase 1 van de AI Act te voldoen. Om je op weg te helpen kan je onderstaand stappenplan volgen. Zo kan je organisatie tijdig en volledig voldoen aan de eerste fase van de AI Act.

Stappenplan implementatie AI Act

1. Inventarisatie van AI-toepassingen

Maak een volledige lijst van alle AI-systemen en toepassingen die binnen de organisatie in gebruik zijn.

- Stel een AI-expertteam samen met medewerkers uit IT, juridische zaken, compliance en businessafdelingen. Dit team is van begin tot eind betrokken bij de implementatie van alle fasen van de AI Act en moet daarom beschikken over voldoende AI-kennis of deze in de komende periode ontwikkelen.

- Beoordeel hoe je deze systemen inzet en of ze mogelijk onder de verboden categorieën vallen volgens de AI Act, zoals manipulatie, social scoring of exploitatie van kwetsbare groepen.

- Raadpleeg juridische experts om zeker te zijn van een juiste interpretatie van de wetgeving in de specifieke context van de organisatie.

- Documenteer de AI-toepassingen die verboden zijn en die je moet uitfaseren.

2. Uitfaseringsplan voor verboden AI-toepassingen

Stel een gedetailleerd plan op voor het uitfaseren van verboden AI-toepassingen, zodat alles vóór 1 februari 2025 voldoet aan de eisen.

- Kies met je AI-expertteam je strategie. Er zijn verschillende opties om verboden AI-systemen uit het dagelijks gebruik te halen:

- De toepassing in zijn geheel niet meer gebruiken.

- De toepassing gebruiken met een alternatieve werkwijze, waardoor je toch aan de regels voldoet.

- De toepassing vervangen door een AI-systeem die wel is toegestaan.

- De toepassing vervangen met menselijk werk.

- Als je strategie bepaald is, maak een tijdlijn en zet duidelijke stappen voor het uitschakelen of vervangen van verboden toepassingen.

- Het team dat verantwoordelijk is voor data en compliance verwijdert of archiveert de bestaande data op een veilige manier.

- Communiceer de aanpassingen en deadlines duidelijk met alle betrokkenen, zoals IT-afdelingen, gebruikers van de toepassing en juridische teams.

3. Training en AI-geletterdheid verhogen

Zorg dat de gebruikers van de AI-systemen in de organisatie AI-geletterd worden.

- Organiseer AI-trainingen voor medewerkers, gericht op:

- Basisprincipes van AI: Wat is AI en hoe werkt het?

- Risico's en ethiek van AI: De ethische overwegingen en risico's van het gebruik van AI in de werkomgeving.

- Specifieke AI-systemen in de organisatie: Hoe ze functioneren en hoe je het op een verantwoorde manier gebruikt.

- Stel een verplicht trainingsprogramma op voor iedereen die direct met AI-systemen werkt.

- Bied herhalingssessies aan en zorg ervoor dat medewerkers hun kennis kunnen toetsen en bijwerken.

4. Monitoring en rapportage

Zorg ervoor dat de organisatie voldoet aan de deadline van 1 februari 2025.

- Voer een interne audit uit om te controleren of alle verboden AI-toepassingen volledig zijn uitgefaseerd.

- Documenteer de uitfasering en zorg dat er een rapportage beschikbaar is die de naleving van de AI Act aantoont.

- Zorg voor continue monitoring van AI-systemen die in gebruik blijven om te garanderen dat ze aan de regelgeving voldoen.

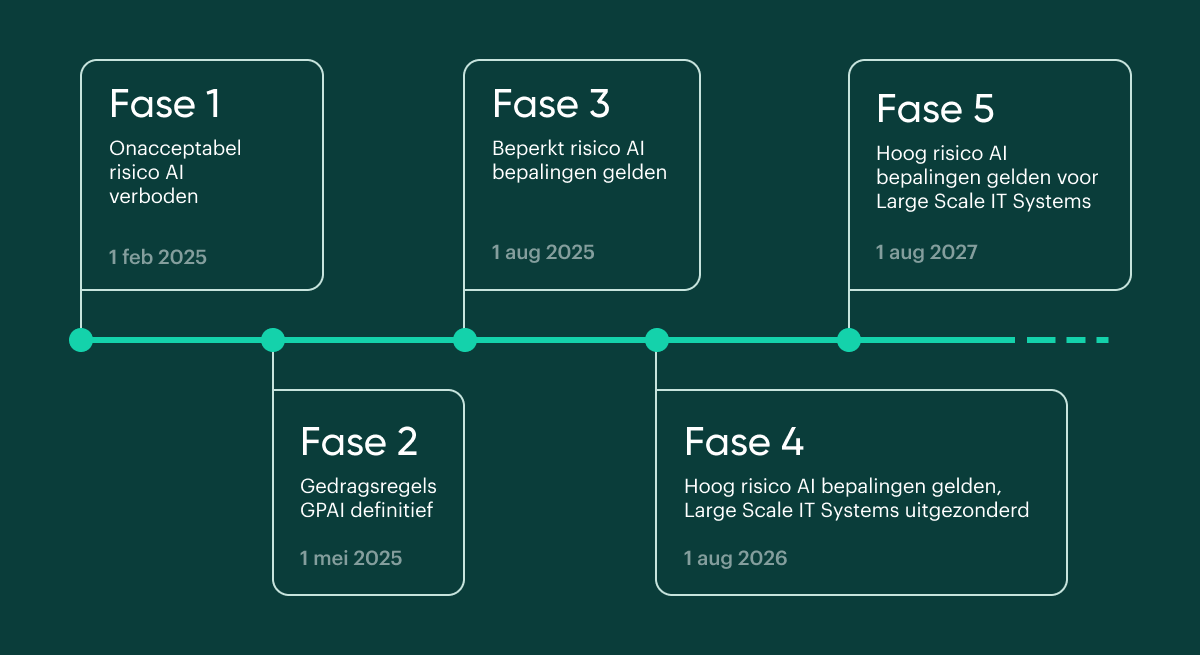

Tijdlijn AI Act

De EU heeft een tijdlijn opgesteld om de AI-verordening volledig door te voeren. Deze ziet er als volgt uit:

-

Fase 1 - 1 februari 2025

Verbod op het gebruik van AI-systemen met een onacceptabel risico. Verplichting tot AI-geletterdheid: medewerkers moeten voldoende vaardigheden, kennis en competenties hebben voor het gebruik van AI.

-

Fase 2 - 1 mei 2025

Deadline opstellen gedragscodes aanbieders General Purpose AI (GPAI*).

-

Fase 3 - 1 augustus 2025

Voldoen aan bepalingen uit categorie beperkt risico:

- GPAI-verplichtingen

- oprichten nationale toezichthouders

- publicatie richtlijnen voor toezicht en boetes

-

Fase 4 - 1 augustus 2026

Voldoen aan bepalingen uit categorie hoog risico, met uitzondering van Large Scale IT-systems.

-

Fase 5 - 1 augustus 2027

Large Scale IT-systems, zoals die voor grenscontroles, moeten ook voldoen aan de eisen van de categorie hoog risico.

* GPAI staat voor General Purpose AI. Dit zijn AI-systemen die je voor meerdere taken kunt inzetten, zonder dat ze vooraf specifiek voor één enkele toepassing zijn ontworpen. Een voorbeeld hiervan is GPT-3, het AI-model dat de basis vormt voor ChatGPT.

Meer informatie

- Meer over AI lees je in onze blog: 'De invloed van AI (artificial intelligence) op de overheid'.

- Website Digitale overheid

- Website EU Artificial Intelligence Act

- AI Act Explorer

- AI Act compliance checker

- Stel je vragen over de AI Act aan het ministerie van Binnenlandse Zaken en Koninkrijksrelaties (BZK): ai-verordening@minbzk.nl

Benieuwd hoe AI jouw documentverwerking kan verbeteren? Of hoe wij deze technologieën in onze software integreren?